Kun yritykset ovat yhä riippuvaisempia datasta liiketoimintansa pyörittämisessä ja kasvattamisessa ja haluavat toteuttaa koneoppimisen käyttötapauksia, jotka vaativat vankan tietoinfrastruktuurin, data engineer roolista tulee entistä tärkeämpi.

Tämä palkkausopas kattaa kaiken tiedon tietotekniikasta, miksi siitä on tullut niin suosittu rooli, mitä data engineer tekee ja kuinka voit palkata seuraavan data engineer onnistuneesti.

Tietoja Data engineering

Data engineering on prosessi, jossa kehitetään ja rakennetaan laajamittaisia tiedonkeruu-, tallennus- ja analysointijärjestelmiä. Se on laaja ala, jota sovelletaan lähes kaikilla toimialoilla. Data engineering- tiimit keräävät ja hallitsevat dataa suuressa mittakaavassa käyttämällä tietämystä ja oikeita tekniikoita varmistaakseen, että tiedot ovat käyttökelpoisessa kunnossa, kun ne saavuttavat datatutkijat, analyytikot ja muut kuluttajat.

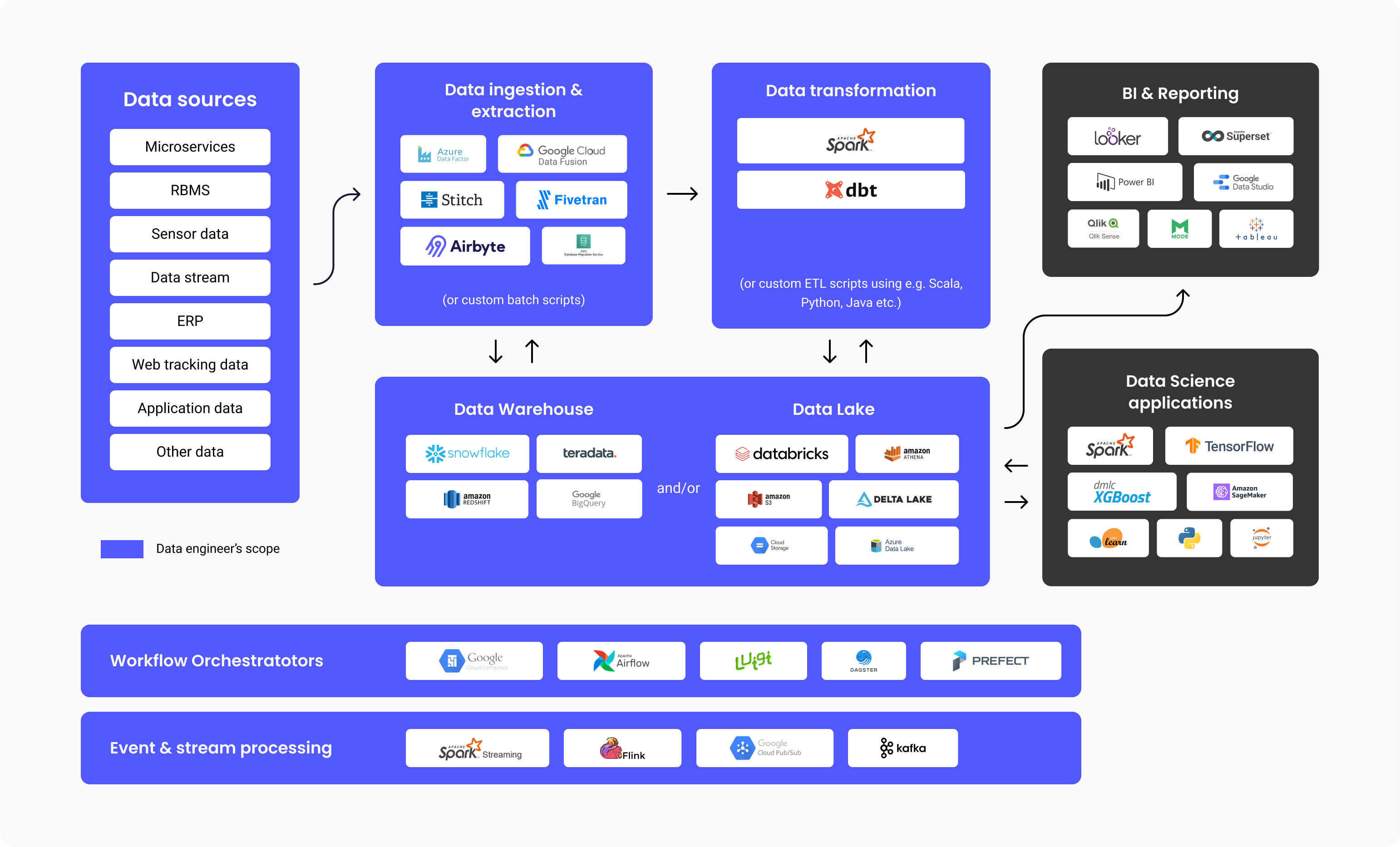

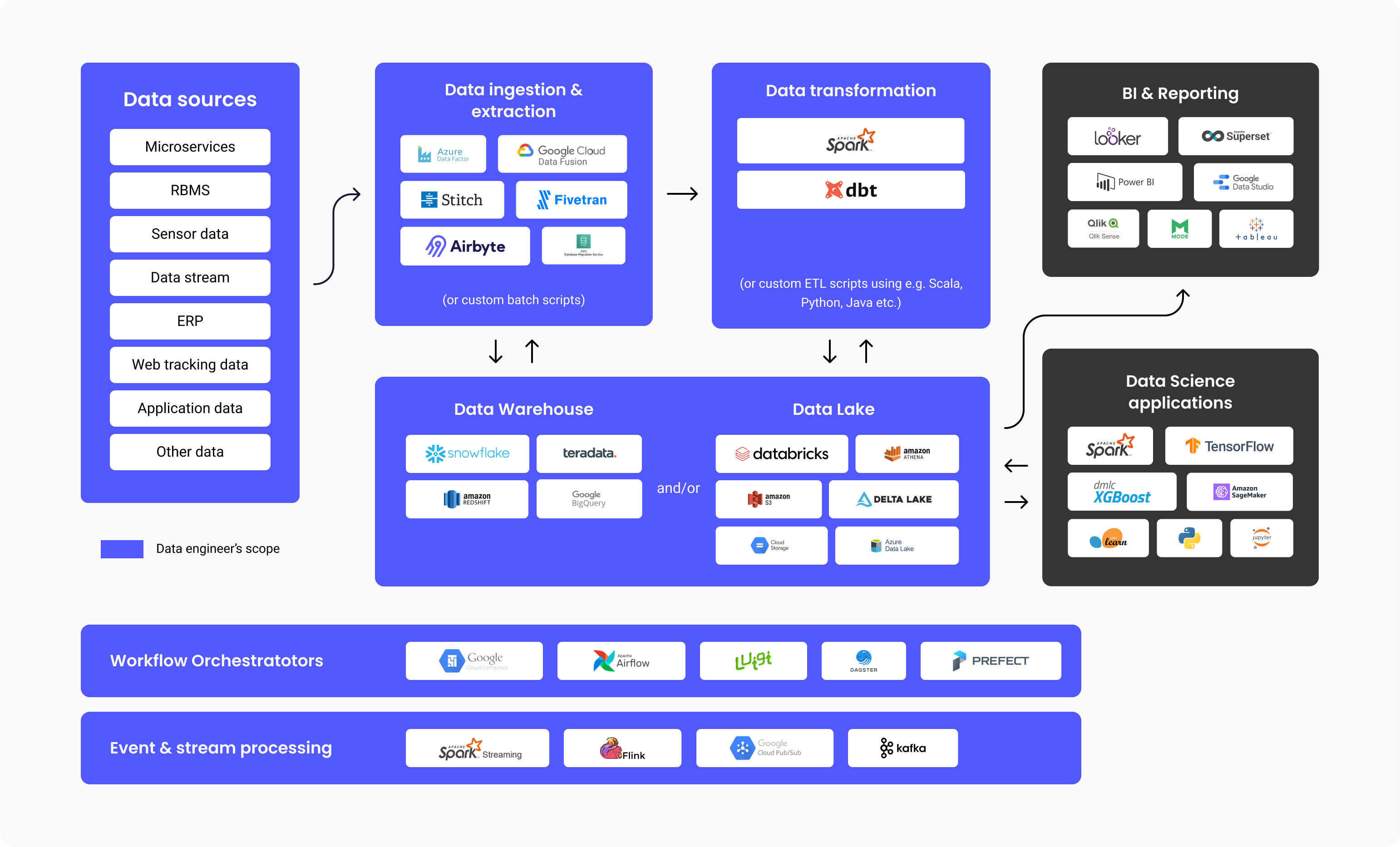

Data engineers rakentavat hajautettuja järjestelmiä, jotka keräävät, käsittelevät ja muuntavat raakadataa käyttökelpoiseksi tiedoksi datatieteen ryhmille, koneoppimis- ja liiketoimintatiedon asiantuntijoille käytettäväksi myöhemmin erilaisissa sovelluksissa.

Data engrineers suunnittelevat ja rakentavat tietoputkia, jotka muuttavat ja siirtävät suuret tiedot erittäin käyttökelpoiseen muotoon, kun ne saavuttavat loppukäyttäjät. Nämä putkistot keräävät yleensä tietoja eri lähteistä tallentaen sen yhteen tietovarastoon tai Data Lake -tietovarastoon, joka edustaa sitä yhtenäisesti yhtenä tietolähteenä.

Yllä oleva kaavio havainnollistaa tietoalustan työnkulkua, kussakin vaiheessa yleisesti käytettyjä tekniikoita ja data engineer vastuualueita. Kuten näet, data engineering tekevät paljon työtä, ennen kuin BI- analyytikot tai datatieteilijät käyttävät sitä. Tutkimukset ovat osoittaneet, että ällistyttävät 80 % datalähtöisiin projekteihin käytetystä vaivannäöstä liittyy data engineering, jotta tiedot saadaan käyttövalmiiksi, kun taas 20 % on arvon luomista tästä tiedosta.

Ei siis ole yllättävää, että Stack Overflow 2021 -tutkimuksen mukaan data engineers palkat liikkuvat keskimäärin 68 034 dollarissa vuodessa, mikä saa tämän ammatin nousemaan palkkakaavioiden yläosaan.

Miksi ja milloin sinun on palkattava data engineer?

Sinun on palkattava data engineer, jos aiot rakentaa sovelluksia tai tietoalustoja (tietovarasto, data- lakes), jotka edellyttävät eri lähteistä tulevien tietojen hakemista ja yhdistämistä.

Tämä tarve syntyy yleensä silloin, kun sinulla on koneoppimiskäyttötapaus, joka vaatii valtavia määriä dataa, tai kun tarvitset keskitetyn arkiston, jonka avulla voit tallentaa kaiken jäsennellyn ja strukturoimattoman tietosi, joka tunnetaan myös nimellä Data Lake tai Data Warehouse.

Data engineer- tyypit

Big Data -keskeinen (data) engineer

Big data engineer keskittyy suurten tietojoukkojen käsittelyyn. Tietojen tallennus tapahtuu tyypillisesti hajautetuissa tiedostojärjestelmissä tai objektitallennusjärjestelmissä relaatiotietokantojen sijaan. Datamäärien käsittelyyn Big Data engineer käyttää tietojenkäsittelykehyksiä, kuten Spark, MapReduce tai Flink. Vaikka SQL: ää käytetään usein, suurin osa ohjelmoinnista tehdään kielillä, kuten Scala, Python tai Java, mikä tekee roolista samankaltaisemman back- end- kehittäjän kanssa. Big Data Engineer käyttää tyypillisesti ETL-prosessia (Extract, Transform, Load) ja rakentaa erä- ja suoratoistodataputkia, jotka tyypillisesti ohjataan työkaluilla, kuten Apache Airflow.

Tietokanta- tai Data warehouse keskeinen data engineer

Tietokanta- tai data warehouse keskeinen data engineer keskittyy ensisijaisesti strukturoidun tiedon poimimiseen ja muuntamiseen relaatiotietokannoista. Tässä prosessissa käytetään vakiotietokannan hallintajärjestelmää, taulukkopohjaista logiikkaa ja menetelmiä, tietokantapalvelimia ja tallennettuja menettelyjä.

Mitä data engineer tekee päivittäin?

Data engineerin velvollisuuksiin ja tehtäviin kuuluu tyypillisesti:

- Infrastruktuurin uudelleensuunnittelun tunnistaminen ja toteuttaminen skaalautuvuuden parantamiseksi

- Tietojen toimituksen optimointi

- Suurten tietojoukkojen kokoaminen

- Rakentaa infrastruktuuria tiedon poimimista ja lataamista varten

- Luo analyyttisiä työkaluja dataputkeen ja tarjoaa tietoa toiminnan tehokkuudesta

Kysyimme myös Proxifyn dataengineer Mehmet Ozan Ünalilta tämän työn sisältämistä päivittäisistä tehtävistä, ja hän kertoi seuraavaa:

"Data engineers luovat yleensä ETL- putkistoja, suunnittelevat skeemoja, sekä valvovat ja ajoittavat putkistoja. Toinen tärkeä tehtävä on tietoinfrastruktuurien suunnittelu ja muotoilu yritykselle. Data engineer tulisi linkittää yhteys tietolähteiden (esimerkiksi SAP), myös IoT: n (esineiden internet) ja sovellusdatan) ja datan kuluttajien (dataanalyytikot, datatieteilijät, liikemiehet, koneoppimisputket, liiketoimintatiedon ja raportointijärjestelmien) välillä.”

Mehmet Ozan Ünal

Mehmet Ozan Ünal

Lyhyesti sanottuna, mitä data engineer tekee:

- Tietoalustojen kehittäminen ja ylläpito

- Raakatietojen syvällinen analyysi

- Kaikkien tietojen laadun ja tehokkuuden parantaminen

- Tietojen poimimisen ja muuntamisen arkkitehtuurien kehittäminen ja testaus

- Dataputkien rakentaminen

- Algoritmien rakentaminen tietojen tehokkaaseen käsittelyyn

- Tietojen luotettavuuden menetelmien tutkiminen

- Tuki analyyttisten työkalujen kehittämisessä

Data engineer haastattelu

Tärkeimmät tekniikat ja ohjelmointikielet data engineer

Mehmet listaa tärkeimmät tekniikat, jotka data engineer on tiedettävä:

- Ohjelmointikielet: SQL ja joko Python, Scala tai Java

- Työkalut ja järjestelmät: Kafka, Spark, Apache Airflow (tietoputkien organisointiin), tapahtumatietokannat (MySQL, PostgreSQL), tietomuodot (Parquet, Protobuf, Avro) Koodaus: versionhallinta (Git), algoritmit ja tietorakenteet

- Säiliöinti: CI/CD- järjestelmät ja Docker

- Pilvi: Azure, GCP tai AWS

Parhaat työkalut, jotka data engineerin tulisi tuntea

On olemassa erityisiä työkaluja, jotka tekevät data engineering tehokkaampaa. Viisi parasta on lueteltu alla:

1. Tietovarastot:

- Amazon Redshift: pilvitietovarasto helppoa tietojen määritystä ja skaalausta varten.

- Google Big Query: pilvitietovarasto, joka sopii erinomaisesti pienille aloittaville yrityksille, jotka haluavat skaalata.

- Snowflake: täysin hallittu SaaS, joka tarjoaa yhden alustan useisiin tarkoituksiin, kuten data engineering, data lakes, tietovarastointiin, datasovellusten kehittämiseen ja muihin tarkoituksiin.

2. Tietojen käsittely ja purkaminen:

- Apache Spark: Avoimen lähdekoodin analytiikkamoottori, jota käytetään tietojen käsittelyyn suuressa mittakaavassa. Se on avoimen lähdekoodin projekti, mutta se on saatavana myös verkkopohjaisena jakeluna, jonka Sparkin perustajat ovat luoneet nimeltä Databricks.

- Google Cloud Data Fusion: Verkkokäyttöliittymä integrointiratkaisujen luomiseen skaalautuvalle datalle tietojen valmistelemiseksi ja muuntamiseksi ilman infrastruktuurimuutoksia.

- Azure Data Factory: Azuren ETL- palvelu (Extract, Transform, Load) tietovirtojen ja integrointitietojen luomiseen ilman palvelimen käyttöä.

3. Tietojen muuntaminen:

- Dbt: Data Build Tool, työkalu tietojen muuntamiseen suoraan varastossa käyttämällä koodia koko prosessia varten.

4. Data Lake ja Lakehouse:

- Databricks: Alusta, joka on yhtenäinen, avoin ja jota käytetään kaikelle datalle, juuri ajoitettuun ja interaktiiviseen data- analyyseihin.

- Amazon S3: Palvelu objektien tallentamiseen ja skaalautumiseen, suorituskykyyn ja tietoturvaan, joka on tallennettu objektimuotoon.

- Google Cloud- tallennustila: Google- palvelu esineiden ja tietojen tallentamiseen Google-pilveen.

- Azure Data Lake: Osana Microsoftia Azure Data Lake on julkinen alusta, joka tarjoaa palveluja ja tuotteita big datan analytiikkaan.

5. Työnkulun järjestäjät:

- Apache Airflow: avoimen lähdekoodin WMS (työnkulunhallintajärjestelmä) -työkalu työnkulun järjestämiseen, ajoittamiseen ja valvontaan.

- Luigi: Python- työkalupaketti putkien rakentamiseen, ajoittamiseen ja organisointiin.

6. Tapahtuman ja streamin käsittely:

- Google Cloud Pub/ Sub: Viestit nopeilla ja välittömillä hälytyksillä ja ilmoituksilla, mikä mahdollistaa rinnakkaisen käsittelyn ja tapahtumapohjaiset arkkitehtuurit.

- Apache Kafka: Tapahtumakauppa ja avoimen lähdekoodin alusta stream-käsittelytoimintoihin.

Data engineer tekniset taidot

Data engineer on oltava nämä tärkeät tekniset taidot:

- Tiedonkeruu – datan määrän, mutta myös lajikkeen ja nopeuden käsittely.

- Koodaus – ohjelmointitaito on elintärkeää, joten he tarvitsevat erinomaisen käsityksen joko Scalasta, Javasta tai Pythonista, jotka ovat yleisimmin käytettyjä kieliä tietotekniikan järjestelmissä ja kehyksissä.

- Tietojen muuntaminen – data engineer on oltava hyvin perehtynyt muuntamiseen, esimerkiksi puhdistamiseen (esim. kaksoiskappaleiden poistamiseen), tietojen yhdistämiseen ja tietojen yhdistämiseen.

- Tietovarastointi – osaa jakaa DW: t tasoihin ja luoda tietotaulukoita yhdistämällä taulukoita ja aggregoimalla niitä tehostaakseen raportointia.

- Tietojen analysointi – kyky saada oivalluksia tietojoukosta, erityisesti kun on kyse laaduntarkistuksista, esim. tietojen jakelu, päällekkäiset tarkastukset jne.

Lisäksi Mehmet sanoi:

”Hyvällä data engineer tulee olla käytännön tietoa ja kokemusta koodauksesta ja tietovarastosta. Tämän lisäksi peruskoneoppiminen, perustietojen mallinnus sekä Linux- ja shell-komentosarjat."

Suosituimmat haastattelukysymykset (ja vastaukset) data engineers arviointiin

Eräs erinomainen tapa arvioida hakijan teknisiä kykyjä on kysyä data engineering- spesifejäkysymyksiä, jotka auttavat erottamaan jyvät akanoista. Testataksesi ja arvioidaksesi data engineerin taitoja ja asiantuntemusta, sekä löytääksesi parhaan ehdokkaan, sinun kannattaa kysyä:

- Kerro Hadoopista ja sen osista.

Odotettu vastaus: Hadoop on avoimen lähdekoodin kehys, jota käytetään käytännölliseen ja tehokkaaseen suurten tietojoukkojen tallentamiseen ja käsittelyyn. Nämä suuret joukot voivat vaihdella gigatavuista petatavuihin, ja Hadoop mahdollistaa tällaisten suurten määrien yksinkertaistetun klusteroinnin.

Aluksi siinä on neljä komponenttia (1 perus/yleinen + 3 ydinkomponenttia) ja lisäkomponentteja, kuten alla selitetään.

- Hadoop Common – Hadoop- peruskirjastojen joukko.

- Hadoop MapReduce – Suuren mittakaavan tietojen käsittelyyn.

- Hadoop YARN – Resurssien hallintaan ja tehtävien ajoitukseen.

- HDFS – Hadoop Distributed File System.

Sitten käytämme myös:

- Hive and Pig – Tietojen käyttöä varten

- Apache Flume, Chukwa, Sqoop – Tietojen integrointiin

- HBase – Tiedon tallennus

- Avro and Thrift – Tietojen sterilointiin

- Drill ja Apache Mahout – Tietojen älykkyyttä varten

- Oozie, Zookeeper ja Ambari – Tietojen hallintaan, orkestrointiin ja seurantaan

- Mitä ovat HDFS: n Block & Block Scanner?

Odotettu vastaus: HDFS: n lohkot ovat pienimmän mahdollisen kokoisia datatiedostoja, ja ne ovat seurausta Hadoopin valtavan kokoisista tiedostoista.

Lohkoskanneri auttaa meitä seuraamaan lohkot sisältäviä listoja ja tunnistaa tarkistussumma- ongelmat kuristuksen avulla (funktion suorittaminen vain kerran, tapahtumien toistoista riippumatta).

- Selitä mitä Reducer on ja sen päämenetelmät.

Odotettu vastaus: Kun käsittelemme tietoja Hadoopissa, Mapper on toinen vaihe ja Reducer kolmas käsittelyvaihe.

Reducerilla on kolme päämenetelmää:

- setup() – Tämän komennon avulla voimme helposti käsitellä parametreja, välimuistia ja määrittää syötetietojen koon.

- cleanup() – Tämän toiminnon avulla voimme poistaa väliaikaiset tiedostot.

- reduce() – Voimme kutsua tätä vain kerran jokaista tehtävänäppäintä kohden, ja tämä on Reducerin ydin.

- Mitä "args" ja "kwargs käytetään"?

Odotettu vastaus: Sekä args että kwargs ovat funktioita. Jos meidän on määritettävä ja käytettävä funktiota komentorivillä ja järjestyksessä, käytämme * args. Muussa tapauksessa, jos meidän on osoitettava joukkoon rivissä olevia, järjestämättömiä argumentteja, jotka siirtyvät funktioihin, käytämme ** kwargsia.

- Vertaa Star Schema ja Snowflake Schema.

Odotettu vastaus: Tietomallinnuksessa on kahden tyyppisiä malleja, Star Schema ja Snowflake Schema.

-

Star Schema on denormalisoinut dimensioiden tai arvojen toistoa yhdessä taulukossa, ja kyselyiden kirjoittaminen on helppoa ilman, että tarvitsee kirjoittaa lisää liitoksia. Se on myös helppo asentaa ja suunnitella. Star Scheman avulla olemme tallentaneet redundantteja tietoja ulottuvuustaulukoihin. Mitä tulee tallennustilaan, Star Schema vaatii enemmän sitä nopeaan suorituskykyyn verrattuna Snowflake Schemaan.

-

Snowflake Schema on tietorakenne, joka on normalisoitu dimensioiden hierarkioilla, jotka on esitetty siististi erillisissä taulukoissa. Tämä kaavio on huomattavasti monimutkaisempi kokonaishuollon kannalta kuin Star. Snowflaken avulla kyselyn kirjoittaminen ei yksinkertaistu, ja tarvitsemme lisää liitoksia ylimääräisten taulukoiden linkittämiseen. Redundantteja tietoja vältetään Snowflake Schema -sovelluksella ja mittataulukot normalisoidaan. Snowflake Schema ei vaadi suurta tallennustilan tarvetta redundanssitekijän vuoksi (joka on tärkeämpi yllä olevassa Starissa).

- Selitä mikä on toissijainen NameNode ja mainitse sen toiminnot.

Odotettu vastaus: Toissijaista NameNodea käytetään muokkausmuutoslokien vastaanottamiseen tietystä nimisolmusta. Näin voimme asettaa ja pitää rajan muokkausten lokikoon.

Toissijaisen NameNoden toiminnot ovat:

- Checkpoint – Käytämme tätä vahvistaaksemme ja varmistaaksemme, että meillä ei ole vioittuneita tietoja.

- FsImage – Käytämme tätä, jos meidän on tallennettava kopio FsImage- tiedostosta tai EditLog- tiedostosta.

- Update – Käytämme Update- toimintoa FsImage- ja EditLog- tiedostojen automaattiseen päivittämiseen.

- NameNoden crash – Jos NameNode todellakin epäonnistuu ja kaatuu, voimme luoda NameNoden uudelleen FsImagen avulla.

- Voitko luetella ja tarkentaa eri lähestymistapoja tietojen validointiin?

Odotettu vastaus: Voimme tarkistaa seuraavat alla luetellut kohdat tietojen validointimenetelmillä:

- Tiedot – Tietotyypin tarkistus mahdollistaa tietojen tarkkuuden tarkistamisen. Emme siis voineet esimerkiksi käyttää kirjainpohjaista tietoa kentässä, joka hyväksyisi vain numeropohjaisen tiedon.

- Alue – Jos meidän on tarkistettava, sisältääkö ennalta määritetty alue syötetietoja, teemme Aluetarkistuksen.

- Koodi: Kun valitsemme tietyn kentän arvoluettelosta, meidän on varmistettava, että luettelo on kelvollinen ja että kenttä on muotoiltu oikein, joten teemme tämän kooditarkistuksen avulla.

- Muoto: Kohtaamme ennalta määritellyn rakenteen, jossa on paljon tietotyyppejä. Muototarkistuksen avulla tarkistamme, ovatko kaikki päivämäärät oikeassa muodossa (esimerkiksi PP/KK-VVVV tai VVVV/KK/PP).

- Ainutlaatuisuus: Ainutlaatuisuustarkistuksen avulla varmistamme, että toistuvia nimikkeitä ei syötetä tuotteista, joiden on oltava luonteeltaan ainutlaatuisia, kuten sähköpostiosoitteen tai ID- sisällön.

- Johdonmukaisuus – Johdonmukaisuuden tarkistamisella katsomme, luotammeko logiikkaan tietojen syöttämisessä selkeän kohteiden järjestyksen ja hierarkian avulla. Esimerkiksi jonkin "valmistuspäivämäärän" jälkeen tulisi kirjoittaa "julkaisupäivä", ei päinvastoin.

- Mikä on DAG Apache Sparkissa?

Odotettu vastaus: DAG (Directed Acrylic Graph) edustaa koodin tulkintaan käytettyä Vertices-joukkoa. Tämä on kaavio, joka tallentaa ja esittää kaikki RDD: n tominnot, ja se on erinomainen tapa luoda ja hallita toimintojen kulkua. Se tarjoaa topologisen järjestyksen ja sekvenssin, sekä siistin visuaalisen esityksen RDD: istä.

- Mikä on Spark "laiska arviointi"?

Odotettu vastaus: "Laska arviointi" Sparkissa edustaa prosessia, jossa toiminto on kutsuttava, muuten prosessia ei suoriteta. Siksi Spark ei ole liian aktiivinen tai huolestunut, kun työskentelemme muunnoksissa, mutta kun kutsumme toimintoa, luodaan DAG (Directed Acrylic Graph). Luonnollisesti kaikki muunnokset ovat hitaita ja laiskoja, joten toiminnot RDD: ssä eivät ala heti. Silloin Spark on hyödyllinen – se lähettää muunnokset DAG: lle, joka suoritetaan, kun kuljettaja pyytää tietopyyntöä.

- Millä tavalla Spark eroaa Hadoop MapReduceen verrattuna?

Odotettu vastaus: Spark on työkalu dataputkien käsittelyyn, hajautettu prosessointijärjestelmä, avoin lähdekoodi ja sitä käytetään big datan käsittelyyn. Hadoop MapReducella on puitteet yksinkertaistettuun kirjoittamiseen sovelluksille, jotka käsittelevät suurta määrää dataa. Nyt kun vertaamme Sparkia ja Hadoop MapReducea, voimme päätellä, että Mapreduce käsittelee levyllä olevia tietoja, mutta Spark käsittelee tietoja muistissa ja säilyttää ne myös siellä. Lisäksi MapReduce on hitaampi käsittelynopeuden suhteen Sparkiin verrattuna.

- Mitä eroa on vasemmalla, oikealla ja sisäliitoksella?

Odotettu vastaus: Vasen, Oikea ja Sisäliitos edustavat kaikki avainsanoja SQL: ssä, joita käytetään rivien yhdistämiseen vähintään kahdessa tai useammassa taulukossa, ja kun niillä on yhteinen sarake jossain niiden välissä.

- Sisäliitos – Käytetään kaikkien rivien valitsemiseen taulukoista. Tämä avainsana yhdistää taulukoiden rivit, joilla on sama yhteinen kenttäarvo.

- Vasen liitos – Tämä avainsana sijoittaa taulukon rivit liitoksen vasemmalle puolelle ja synkronoi myös oikean sivutaulukon rivit.

- Oikea liitos – Tämä avainsana tuo takaisin rivit liitoksen oikealla puolella olevaan taulukkoon, mutta synkronoi vasemman sivutaulukon rivit. Se on melko samanlainen kuin vasemmistoliitos.

- Voitko määritellä tietojen normalisoinnin?

Odotettu vastaus: Puhtaan datan luontiprosessi tunnetaan yleisesti tietojen normalisoimisena, eli tietojen järjestämisenä ja sen yhtenäisen muodon määrittelynä useissa kentissä ja tietueissa. Tietojen normalisointi auttaa poistamaan tietoja, joita ei ole jäsennelty tai kopioitu, jolloin jäljelle jää vain loogista ja käytettyä tallennustilaa.

Mahdollisia haasteita data engineer palkkaamisen aikana

Uuden henkilön palkkaamisessa on aina haasteita ammatista ja työn vaatimuksista riippumatta.

Yksi suuri haaste on se, että data Engineer laajuudesta on tullut laaja ja hämmentävä. Sitä ei pidä sekoittaa seuraaviin liittyviin rooleihin:

- Database Administrator (DBA), joka keskittyy enemmän OLTP- tietokantojen luomiseen ja optimointiin.

- Dataanalyytikot, jotka yleensä keskittyvät enemmän liiketoiminnan arvon kasvattamiseen luomalla hallintapaneeleja ja ad hoc- raportteja.

- Analyysi- insinööri, joka on samanlainen kuin data- analyytikon rooli, mutta jolla on enemmän ohjelmistosuunnittelijan taitoja (versionhallinta, CI/CD, Python/Scala/Java) ja joka keskittyy tyypillisesti SQL- putkien tietovarastointiin ja optimointiin.

- Koneoppimisinsinööri, joka on taitava ottamaan käyttöön Data Scientistsin rakentamia ML-malleja tuotantoon. Se vaatii syvempää tilastojen, algoritmien ja matematiikan ymmärtämistä. Joillakin data engineers on tämä tieto, mutta keskikokoiselle ja suurelle datatiimille sen pitäisi olla oma roolinsa.

On korostettava, että palkkaavilla esimiehillä/työnantajilla on melko usein tapana tarjota data engineer pienempää palkkaa tai alle markkina- arvon. Tämän tyyppinen "haaste" kuuluu rekrytointipäälliköille, jotka erehdyksessä keskittyvät intensiivisesti kaikkeen paitsi siihen pitkän aikavälin hyötyyn, että yrityksessä on ammattitaitoinen data engineer.

Mikä erottaa erinomaisen data engineer hyvästä?

Data engineer rooliin parhaiten sopivan ehdokkaan valitseminen voi olla hankalaa, varsinkin jos vähintään kahdella ehdokkaalla on samanlainen kokemus ja asiantuntemus. Aina erottuu kuitenkin joukosta syvällisillä tiedoilla, teknisten taitojen hallitsemisella ja ennakoivalla, dynaamisella ajattelutavalla.

Erinomainen data engineer:

-

Luo helposti ylläpidettäviä ratkaisuja.

Jos esimerkiksi vaaditaan manuaalinen tietojen kartoitus tietojen puhdistamiseen, koodaako kehittäjä arvot vai luoko se konfigurointitiedoston, joka voidaan helposti päivittää?

-

Ymmärtää liiketoiminnan tarpeet eikä suunnittele ratkaisuja liikaa

Tarvittavaa monimutkaisempien ratkaisujen rakentamisen ansaan on helppo pudota. Tämä voisi olla esimerkiksi lähes reaaliaikaisen suoratoistoputken rakentaminen, kun todellinen tiedon päivitystarve on päivittäin.

Älä unohda, että tiimipelaajana oleminen on erityisen tärkeää, koska data engineer tulee säännöllisesti kommunikoida muiden tiimissä eri rooleissa olevien (Data Scientist, Data Analyst, ML Engineer jne.) ja muiden yritystiimien kanssa.

Data egineering arvo

Kaikki yritykset voivat hyötyä data engineering, koska ne antavat yrityksille mahdollisuuden tulla tietoisemmiksi. Se saattaa kuulostaa epämääräiseltä, mutta data engineering on perusta, jonka tarvitset tehdäksesi datasta helposti kulutettavia ja tarkkoja ja mahdollistaaksesi edistyneen analytiikan ja koneoppimisen käyttötapaukset. Kuten edellä mainittiin, 80 % minkä tahansa dataprojektin vaivannäöstä käytetään data engineering.

Yhteenvetona Mehmet selventää:

"Data engineers ovat vastuussa yrityksen läpi kulkevan tietovirran suunnittelusta sekä tietoputkien luomisesta ja automatisoinnista tämän virran toteuttamiseksi."

Tällaisen henkilön tai tiimin kanssa yritys voi luottaa tietoihin ja luottaa siihen ja tietää, että se on hyvissä käsissä ja data engineers keräävät, tallentavat ja käsittelevät tiedot virheettömästi, mikä on ensimmäinen askel kohti datalähtöistä yritystä.

English

English

Norsk

Norsk